1月27日,根据市场研调机构Counterpoint Research最新发布的数据中心 AI服务器计算 ASIC (应用专用集成电路)出货量预测和跟踪报告显示,预计到 2027 年, AI 服务器专用的AI计算ASIC芯片出货量将比 2024 年增长200%。

这一爆炸性增长的背后,是对谷歌 TPU基础设施(用于支持 Gemini)的强劲需求、亚马逊AWS Trainium 集群的持续扩展,以及 Meta (MTIA系列芯片) 和微软 (Maia系列芯片)随着其内部芯片产品组合的扩展而带来的部署量提升。

针对面向数据中心的AI ASIC市场的增长,Counterpoint Research研究副总裁Neil Shah表示:“头部企业内部AI服务器所需的AI ASIC设计的增长,正在验证内部定制XPU时代的到来。在这个时代,AI加速器针对特定工作负载(训练或推理)量身定制,其结构不再仅仅依赖通用GPU。随着电力和空间成为瓶颈,将部分AI工作负载迁移到定制的ASIC芯片上,不仅能让超大规模数据中心运营商拥有更大的控制权和优势,还需要大量的软件支持来优化AI工作负载,从而享受性能和效率的提升。”

Shah补充道:“形势瞬息万变,我们预计到2028年,全球数据中心AI ASIC芯片的出货量将突破1500万颗,超过数据中心GPU的出货量。排名前十的AI超大规模数据中心运营商在2024年至2028年期间累计部署的AI服务器所需的AI ASIC芯片将超过4000万颗。此外,超大规模AI数据中心运营商基于其内部技术栈(例如Google TPU Pods和AWS Trainium UltraClusters)构建的大型机架级AI基础设施也支撑着这一前所未有的需求,使它们能够像一台超级计算机一样运行。”

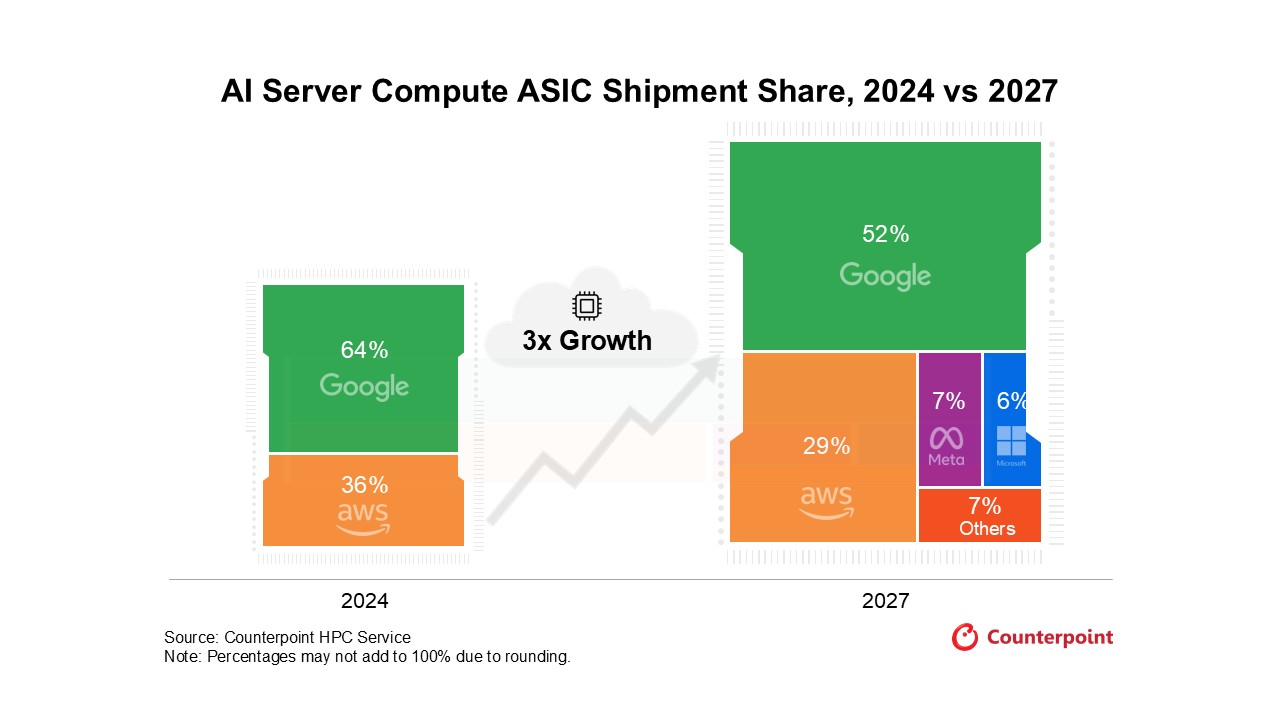

就超大规模AI数据中心所需的AI ASIC芯片的出货量市场格局而言,市场将从2024年的谷歌(64%)、亚马逊AWS(36%)的双寡头格局,逐步转变为更为多元的格局。特别是随着Meta与微软扩大内部AI ASIC芯片的部署,预期到2027年他们的出货量占比将进一步增长,将分别达到7%和6%。届时谷歌和亚马逊AWS的份额将分别降低至52%和29%。这一转变凸显了超大规模数据中心运营商的战略转型,即摆脱对于英伟达(NVIDIA)GPU芯片的依赖,转而扩大内部定制芯片的采用比例,以优化其特定工作负载的每瓦性能,并降低采购成本。

Counterpoint Research研究员David Wu 强调:“尽管由于市场规模不断扩大,以及竞争对手(如通过博通、Marvell和Alchip等设计服务公司帮助定制ASIC)纷纷采用自研芯片,预计谷歌的市场份额将在2027年下降至52%,但其TPU集群仍将是无可争议的行业核心和标杆。这一基准的支撑源于训练和运行下一代Gemini模型所需的庞大且持续的计算能力,而这又需要谷歌持续、积极地扩充其内部芯片基础设施。”

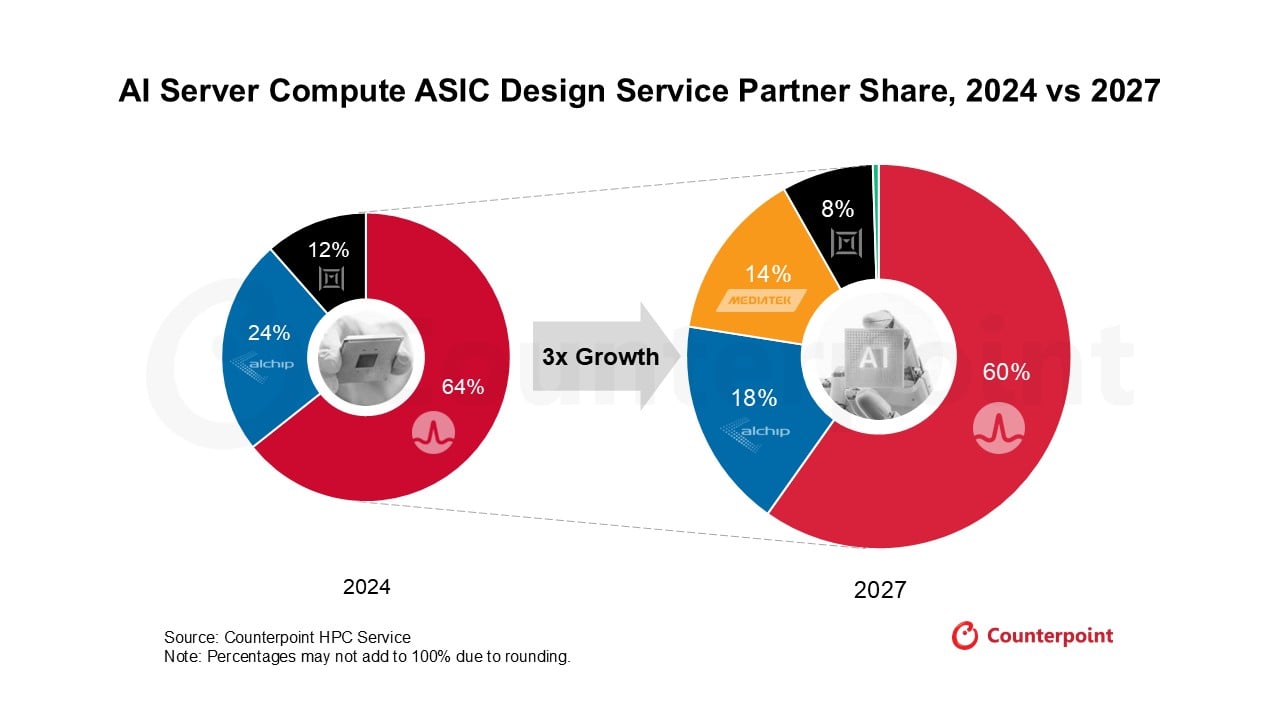

从AI服务器所需的ASIC设计服务厂商的市场根据格局来看,2024年,博通以高达64%的市场份额占据了大部分的市场,Alchip(世芯电子)和Marvell的份额分别只有24%和12%。但是这个三家企业独占的市场格局,随着联发科的加入,将会在2027年被彻底打破。联发科有望通过为谷歌提供TPU定制服务,在2027年拿到14%的市场份额,博通、Alchip和Marvell的份额则分别降至了60%、18%和8%。

Counterpoint Research副总监Brady Wang表示:“虽然博通一直是AI服务器所需的AI ASIC设计合作伙伴的首选,但它将面临来自新兴的谷歌-联发科联盟日益激烈的竞争压力。这种转变在谷歌即将推出的TPU v8系列中最为明显,谷歌正在采用双供应来源采购策略——博通在高性能TPU v8AX‘Sunfish’(训练芯片)方面保持领先地位,而联发科则获得了专注于推理的TPU v8x‘Zebrafish’的设计合作。”

尽管联发科的大规模量产进程比原计划晚了大约一年,但其进军数据中心领域对博通长期以来的市场主导地位构成了严峻挑战。Brady Wang补充道:“博通虽然在知识产权方面仍然拥有强大的竞争优势,并且在处理复杂的训练工作负载方面提供业界领先的效率,但其高昂的定价策略与联发科更具成本效益的方案形成了鲜明对比。随着谷歌积极扩展其全球基础设施,对于该公司而言,实现供应链多元化并利用联发科低成本的解决方案来处理大规模部署的推理任务,已成为一项战略要务。”

中国台湾芯片设计服务商Alchip(世芯电子)也正积极拓展亚马逊AWS供应链,力图重夺市场地位,并有望在未来几年成为AWS的主要设计合作伙伴之一。Counterpoint Research的供应链调查显示Alchip即将加入AWS供应链,这意味着Marvell在AWS Trainium未来发展路线图方面可能面临日益激烈的竞争压力。微软的Maia系列芯片是AI服务器所需的AI ASIC芯片的主要增长点,Marvell将致力于产品线多元化。预计到2027年,随着竞争加剧,Marvell的市场份额将下滑至8%,但Counterpoint Research仍然认为其出货量将在2024年至2027年间翻一番。

谈及Marvell未来几年的竞争地位,Counterpoint Research副总监Gareth Owen强调:“确保获得新的全新设计订单至关重要,这有助于降低其增长风险,并防止在当前Trainium系列产品发布后出现潜在的收入空档期。尽管如此,Marvell的端到端定制芯片产品组合比以往任何时候都更加稳固,这得益于其定制硅创新,例如定制的HBM /SRAM存储器和PIVR解决方案,以及对Celestial AI的收购,这些都扩大了Marvell在规模化连接领域的潜在市场。Celestial AI不仅每年可以为Marvell带来数十亿美元的收入增长,而且有可能在未来几年内推动Marvell在光规模化连接领域占据领先地位。我们相信,这些创新对于Marvell未来的定制XPU和XPU附加组件业务至关重要,并有助于其在未来几年内提升市场份额。”